Un sistem AI a atins nivelul uman la un test de „inteligență generală”

Un nou model de inteligență artificială (AI) a obținut recent rezultate la nivel uman la un test conceput pentru a măsura „inteligența generală”.

Pe 20 decembrie, sistemul o3 al OpenAI a obținut un scor de 85% la benchmark-ul ARC-AGI, cu mult peste cel mai bun scor AI anterior de 55% și la egalitate cu scorul mediu uman. De asemenea, a dat rezultate bune la un test de matematică foarte dificil.

Crearea inteligenței generale artificiale, sau AGI, este obiectivul declarat al tuturor laboratoarelor majore de cercetare AI. La prima vedere, OpenAI pare să fi făcut cel puțin un pas semnificativ către acest obiectiv, explică doi specialiști în domeniu în publicația The Conversation .

În timp ce scepticismul rămâne, mulți cercetători și dezvoltatori AI simt că ceva tocmai s-a schimbat. Pentru mulți, perspectiva AGI pare acum mai reală, urgentă și mai apropiată decât se anticipase.

Generalizare și inteligență

Pentru a înțelege ce înseamnă rezultatul o3, trebuie să înțelegem despre ce este vorba în testul ARC-AGI. În termeni tehnici, este un test al „eficienței eșantionului” a unui sistem AI în adaptarea la ceva nou - câte exemple de situație nouă trebuie să vadă sistemul pentru a-și da seama cum funcționează.

Un sistem AI precum ChatGPT (GPT-4) nu este foarte eficient în eșantionare. A fost „antrenat” pe milioane de exemple de text uman, construind „reguli” probabilistice despre combinațiile de cuvinte care sunt cele mai probabile.

Rezultatul este destul de bun la sarcini comune. Este prost însă la sarcini neobișnuite, pentru că are mai puține date (mai puține mostre) despre acele sarcini.

Până când sistemele AI pot învăța dintr-un număr mic de exemple și se pot adapta cu mai multă eficiență a eșantionului, acestea vor fi utilizate numai pentru lucrări foarte repetitive și pentru cele în care defecțiunile ocazionale sunt tolerabile.

Capacitatea de a rezolva cu acuratețe probleme necunoscute sau noi din eșantioane limitate de date este cunoscută drept capacitatea de a generaliza. Este considerat pe scară largă un element necesar, chiar fundamental, al inteligenței.

Grile și modele

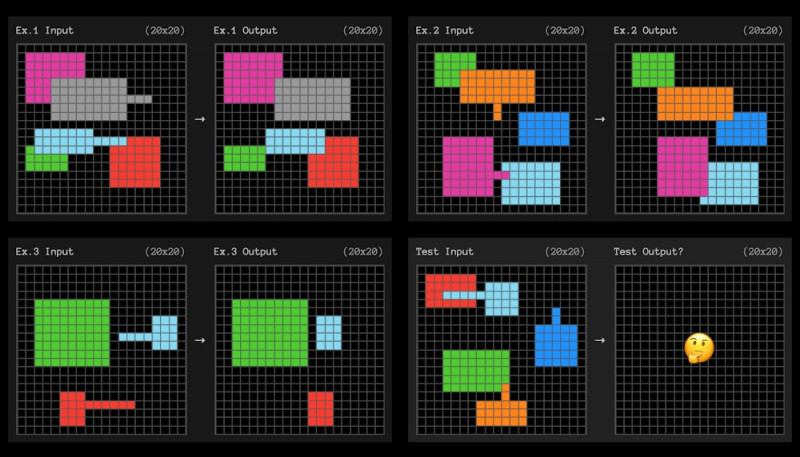

ARC-AGI testează pentru adaptarea eficientă a eșantionului utilizând probleme mici cum ar fi cea de mai jos. AI trebuie să descopere modelul care transformă grila din stânga în grila din dreapta.

Exemplu de sarcină la testul ARC-AGI Foto: ARC Prize

Exemplu de sarcină la testul ARC-AGI Foto: ARC Prize Fiecare întrebare oferă trei exemple din care să înveți. Sistemul AI trebuie apoi să descopere regulile care „generalizează” de la cele trei exemple la al patrulea.

Reguli slabe și adaptare

Nu știm exact cum a făcut OpenAI, dar rezultatele sugerează că modelul o3 este foarte adaptabil. Din doar câteva exemple, găsește reguli care pot fi generalizate.

Pentru a descoperi un model, nu ar trebui să facem presupuneri inutile sau să fim mai specifici decât trebuie să fim cu adevărat. În teorie, dacă poți identifica regulile „cele mai slabe” care fac ceea ce vrei, atunci ți-ai maximizat capacitatea de a te adapta la situații noi.

Ce înțelegem prin cele mai slabe reguli? Definiția tehnică este complicată, dar regulile mai slabe sunt de obicei cele care pot fi descrise în afirmații mai simple.

Lanțuri de gândire

Deși nu știm încă cum OpenAI a obținut acest rezultat, pare puțin probabil să fi optimizat în mod deliberat sistemul o3 pentru a găsi reguli slabe. Cu toate acestea, pentru a reuși la sarcinile ARC-AGI, trebuie să le găsești.

Știm că OpenAI a început cu o versiune de uz general a modelului o3 (care diferă de majoritatea celorlalte modele, pentru că poate petrece mai mult timp „gândindu-se” la întrebări dificile) și apoi l-a antrenat special pentru testul ARC-AGI.

Cercetătorul francez de inteligență artificială Francois Chollet, care a proiectat benchmark-ul, consideră că o3 caută prin diferite „lanțuri de gândire” care descriu pașii pentru rezolvarea sarcinii. Apoi ar alege „cel mai bun” conform unei reguli vag definite sau „euristice”.

Ceea ce încă nu știm

Dacă așa funcționează o3, atunci modelul de bază ar putea să nu fie cu mult mai bun decât modelele anterioare. Conceptele pe care modelul le învață din limbaj s-ar putea să nu fie mai potrivite pentru generalizare decât înainte. În schimb, este posibil să vedem doar un „lanț de gândire” mai generalizabil, găsit prin pașii suplimentari de pregătire a unei euristice specializate pentru acest test.

Aproape totul despre o3 rămâne necunoscut. OpenAI a limitat dezvăluirea la câteva prezentări media și testarea timpurie pentru câțiva cercetători, laboratoare și instituții de siguranță AI.

Înțelegerea cu adevărat a potențialului o3 va necesita o muncă extinsă, inclusiv evaluări, o înțelegere a distribuției capacităților sale, cât de des eșuează și cât de des reușește.

Când o3 va fi lansat în sfârșit, vom avea o idee mult mai bună dacă este aproximativ la fel de adaptabil ca un om obișnuit.

Dacă da, ar putea avea un impact economic uriaș, revoluționar, deschizând o nouă eră a inteligenței accelerate care se auto-îmbunătățește. Vom avea nevoie de noi puncte de referință pentru AGI în sine și de o analiză serioasă a modului în care ar trebui să fie guvernată. Dacă nu, atunci acesta va fi totuși un rezultat impresionant. Cu toate acestea, viața de zi cu zi va rămâne aproape aceeași, susțin specialiștii.