Noul război? Amănunte care dau fiori...

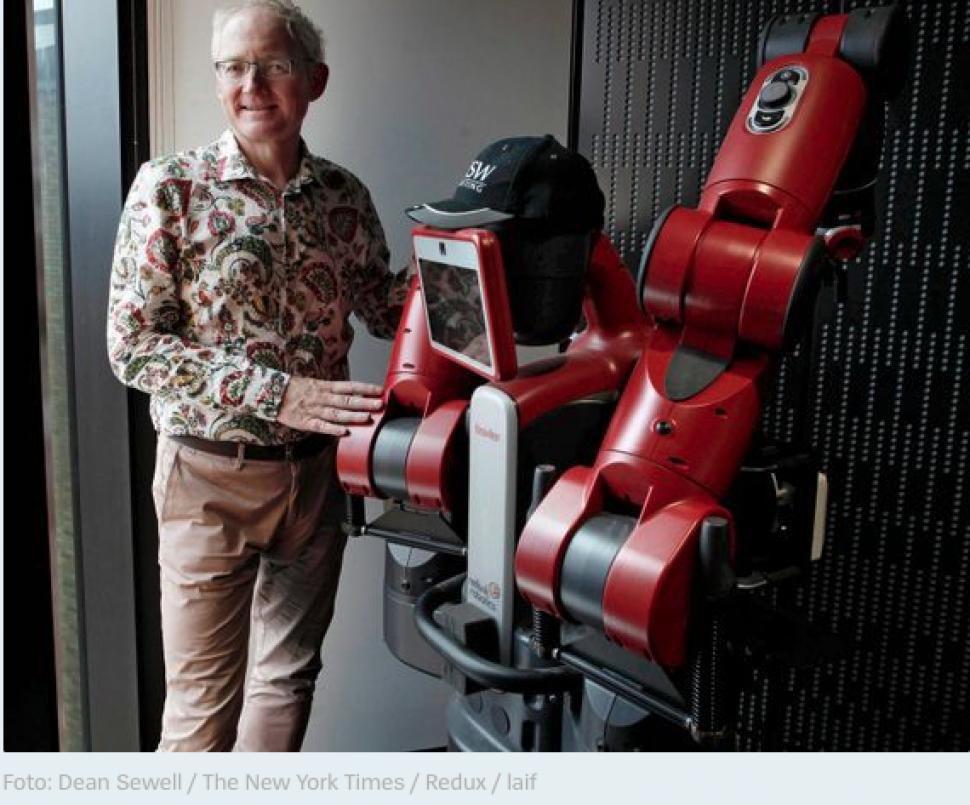

Într-un interviu pentru publicația germană Der Spiegel , expertul australian în tehnologie Toby Walsh discută despre efectele potențial devastatoare ale utilizării inteligenței artificiale pe câmpul de luptă. Nu putem scăpa de AI, spune el, dar trebuie să o aducem în concordanță cu valorile societății.

DER SPIEGEL: Războiul de agresiune rusesc împotriva Ucrainei pare uneori un test pentru sistemele de arme moderne. Ucraina s-a bazat foarte mult pe dronele turcești Bayraktar de la început, iar acum Rusia ar putea urma exemplul cu dronele iraniene. Ar putea aceste arme să fie folosite și în mod autonom în viitor, controlate cu ajutorul inteligenței artificiale (AI)?

Walsh: Da, utilizarea roboților ucigași controlați de AI este doar o chestiune de timp. Tocmai am avertizat într-un eseu despre un nou tip de mină antipersonal rusă numită POM-3. POM-3 se bazează pe un design german al Wehrmacht numit Schrapnellmine, numit în glumă „Bouncing Betty” de către soldații aliați. Asta pentru că această mină detectează pași, sare mai întâi în aer și apoi detonează la o înălțime de un metru pentru a sfârteca cât mai mulți soldați cu schije. Rusia a anunțat că va controla această mină folosind un software AI care poate distinge cu precizie dacă propriile sale unități rusești se apropie, caz în care nu va exploda sau dacă sunt soldați inamici, caz în care se va declanșa. Astfel de mine sunt groaznice. De aceea sunt scoase în afara legii la nivel internațional; 164 de state s-au angajat să nu le folosească, inclusiv Ucraina. Rusia nu se numără printre ele. Critica mea la adresa POM-3 mi-a dat acces la un club: am ajuns pe o listă cu interdicție de intrare și nu mai am voie să călătoresc în Rusia. O iau ca pe un compliment.

DER SPIEGEL: Forțele aeriene mondiale par să fie cu un pas înainte. Forțele aeriene australiane, de exemplu, testează în prezent noi tipuri de drone de luptă cu reacție semi-autonome împreună cu compania americană Boeing. Aceste drone interceptoare sunt menite să ofere piloților de bombardiere protecție de escortă ca așa-numit „camarad loial” (loyal wingman).

Walsh: Termenul „loyal wingman” este eufemistic și înșelător, sugerând că este vorba pur și simplu despre protejarea vieții umane, în acest caz a vieții piloților. Dar este vorba de fapt despre cu totul altceva: o cursă globală a înarmărilor AI a fost în desfășurare de mult timp, despre care publicul nu a fost în mare parte conștient până acum. Armata SUA dezvoltă un tanc robot numit Atlas. Marina SUA lucrează la o navă de război robotizată complet automatizată numită Sea Hunter, care a încheiat deja în mod autonom o călătorie din Hawaii până pe coasta Californiei. China dezvoltă, de asemenea, rachete controlate de AI. Și Rusia vrea să dezvolte un submarin autonom, fără pilot, numit Poseidon, care poate fi echipat chiar cu arme nucleare. E un coșmar. Vă puteți gândi la ceva mai terifiant decât un submarin în care, în loc de un căpitan, un program de calculator decide dacă începe un război nuclear?

DER SPIEGEL: Nu sunt acestea scenarii de groază care nu se împlinesc până la urmă?

Walsh: Deloc. Armele autonome sunt poate chiar mai periculoase decât bombele nucleare. Asta pentru că construirea unei bombe nucleare necesită o cantitate incredibilă de know-how, ai nevoie de fizicieni și ingineri remarcabili, ai nevoie de material fisionabil, ai nevoie de mulți bani. Prin urmare, din fericire, armele nucleare nu vor fi la îndemâna multor țări în viitorul apropiat. Cu armele AI, pe de altă parte, situația este destul de diferită. Adesea, sistemele de arme convenționale pe care fiecare mic lord războinic le are la dispoziție sunt suficiente; cu cipurile de computer și accesoriile adecvate de la o imprimantă 3D, acestea sunt apoi transformate într-o armă autonomă.

DER SPIEGEL: Ar fi asemenea arme sau câteva tancuri autonome Atlas sau fregate Sea Hunter cu adevărat decisive pentru război?

Walsh: Nu știu, dar ar putea declanșa accidental un război printr-o defecțiune, care ar fi apoi luptat cu arme convenționale sau echipamente de război și mai groaznice pe parcurs. Rusia, de exemplu, ar fi folosit o armă hipersonică în invazia sa din Ucraina, zburând spre ținta sa cu o viteză supersonică de multe ori. Într-un astfel de caz, apărătorii au puțin timp să reacționeze sau să excludă o alarmă falsă. Acest lucru accelerează războiul. Ar putea duce la un „război fulger”, un blitzkrieg în care sistemele informatice inamice se răscolesc reciproc în cel mai scurt timp posibil. Această automatizare a războiului are un efect destabilizator. Trebuie să prevenim asta cu orice preț.

DER SPIEGEL: Nu pot și armele semiautonome să salveze vieți? Sistemul american de apărare antirachetă Phalanx pentru apărarea navelor de război, de exemplu, răspunde la atacuri mult mai rapid decât ar putea un om.

Walsh: Sigur, dacă trebuie să te aperi de o armă hipersonică, e un lucru bun. Dar Phalanx este în mod clar un sistem defensiv. AI este de fapt mai puțin problematică cu armele defensive. Și totuși, utilizarea sa este, de asemenea, dificilă. Cât de fiabil este un astfel de sistem? Ce se întâmplă dacă software-ul recunoaște în mod eronat un avion de pasageri ca fiind o rachetă inamică și îl distruge?

DER SPIEGEL: Cine poartă răspunderea dacă armele robotizate comit crime de război? Încă din 2017, în Parlamentul European s-a discutat serios despre acordarea unor mașinării ceva asemănător statutului de persoană specială, pentru a putea fi trase la răspundere în cazul unei abateri.

Walsh: Da, dar la ce ar folosi asta? La urma urmei, corporațiile sunt considerate și „persoane juridice” în unele țări. Dar asta de multe ori nu este de mare ajutor atunci când vine vorba de crime.

DER SPIEGEL: Sunt deja folosiți roboții criminali ofensivi?

Walsh: Există multe speculații. Dar se pare că Turcia a trimis o dronă autonomă numită Kargu cu software de recunoaștere facială pentru a vâna oameni la granița cu Siria. Se pare că Kargu folosește aceiași algoritmi de recunoaștere facială ca și în smartphone-ul tău, cu toate erorile lor, pentru a identifica și ucide oameni pe teren. Imaginează-ți cât de înfricoșător ar fi să fii urmărit de un roi de drone ucigașe. Chiar dacă nu funcționează în mod deosebit de fiabil, desigur, dictaturile le-ar putea folosi pentru a îngrozi populația. Ar fi ideal pentru teroarea de stat.

DER SPIEGEL: Ar fi încă realist să scoți în afara legii armele controlate de AI, de exemplu printr-o contrapartidă la Tratatul de neproliferare nucleară, așa cum sugerezi în noua ta carte?

Walsh: Ei bine, scoaterea în afara legii poate să nu funcționeze întotdeauna perfect, dar poate preveni ce e mai rău. Există destul de multe exemple de arme care au fost folosite inițial, dar ulterior au fost scoase în afara legii. Gândiți-vă la utilizarea pe scară largă a gazelor otrăvitoare în Primul Război Mondial. Sau gândiți-vă la laserele orbitoare, care îi pot orbi pe soldați. Au fost scoase în afara legii printr-un protocol al Națiunilor Unite în 1998 și nu au mai apărut aproape niciodată pe câmpurile de luptă de atunci, deși tehnologia laserului civil este, după cum știm, utilizată pe scară largă. Pentru minele antipersonal, interdicția nu funcționează la fel de bine, dar cel puțin 40 de milioane dintre ele au fost distruse ca urmare a protocoalelor de scoatere în afara legii, salvând viețile multor copii. Este o poveste similară cu munițiile cu dispersie: aproximativ 99% din stoc a fost distrus, chiar dacă au fost folosite din nou în Siria. Ne putem asigura că armele autonome devin inacceptabile prin stigmatizarea lor.

DER SPIEGEL: În urmă cu doar patru ani, ai prezis un viitor glorios pentru AI în bestsellerul tău „It’s Alive”. Ce a dus la schimbarea părerii tale?

Walsh: Realitatea s-a întâmplat! Tocmai am văzut o mulțime de efecte secundare neplăcute ale AI. Treptat, a devenit din ce în ce mai clar în ce măsură publicitatea electorală a fost folosită pentru a pătrunde mintea oamenilor să voteze pentru Donald Trump sau pentru Brexit, ceea ce este adesea împotriva propriilor interese. Și prin programe de auto-învățare, aceste atacuri s-au transformat într-o furtună perfectă.

DER SPIEGEL: Vă dă speranță că Uniunea Europeană lucrează în prezent la o directivă privind „AI de încredere”?

Walsh: UE conduce într-adevăr calea când vine vorba de reglementarea AI. Și piața europeană este suficient de mare încât merită ca corporațiile globale să își adapteze produsele AI la regulile europene. Cu toate acestea, diavolul este în detalii. Formularea regulilor este un lucru, dar întrebarea este cât de energic va fi apoi aplicată respectarea regulilor.

DER SPIEGEL: Există deja diferențe considerabile de opinii în fazele preliminare, de exemplu cu privire la problema transparenței. Poate AI să fie cu adevărat transparentă și inteligibilă – sau este întotdeauna, prin definiție, parțial o cutie neagră?

Walsh: Transparența este supraevaluată. Nici oamenii nu sunt transparenți – totuși, adesea avem încredere în ei în viața de zi cu zi. Am încredere în medicul meu, de exemplu, deși nu sunt un profesionist medical și nu pot înțelege deciziile sale în detaliu. Și chiar dacă habar n-am ce se întâmplă în interiorul său. Dar am încredere în instituțiile care îmi monitorizează medicul.

DER SPIEGEL: Cum ne putem asigura că un AI funcționează conform regulilor, chiar dacă nu îi cunoaștem codul în detaliu?

Walsh: Aceasta este o problemă dificilă, dar nu se limitează la AI. Companiile moderne sunt, de asemenea, o formă de inteligență supraumană. Nici măcar cea mai inteligentă persoană de pe planetă nu și-a putut construi singur un iPhone. Nimeni nu este suficient de inteligent pentru a proiecta singur o centrală electrică. Fiecare mare corporație interconectează inteligența a zeci de mii de angajați cu inteligență moderată pentru a forma un colectiv supraomenesc de inteligent – cu alte cuvinte, un fel de inteligență artificială, cum ar fi.

DER SPIEGEL: Nu am putea pur și simplu să scoatem din priză un sistem AI care se comportă prost și gata?

Walsh: În niciun caz! Nu putem doar să oprim computerele sistemului bancar global, atunci economia globală s-ar prăbuși. Nu putem opri nici calculatoarele de control al traficului aerian, atunci traficul s-ar prăbuși. De asemenea, nu putem opri computerele centralelor electrice, pentru că atunci am experimenta o întrerupere. Suntem deja total dependenți de computere astăzi. Această dependență doar crește cu AI. Nu putem scăpa de ea. Putem încerca doar să ne asigurăm că valorile AI sunt în armonie cu valorile societății noastre.

DER SPIEGEL: Odată ați prezis corect că o mașină cu conducere autonomă va provoca un accident mortal cu un biciclist și un pieton, ceea ce s-a întâmplat exact un an mai târziu. Ce preziceți pentru următorii cinci ani?

Walsh: Cu recunoașterea facială automată, vom vedea scandaluri. Startup-ul american Clearview AI a adunat milioane de fotografii fără acordul persoanelor implicate. Compania a fost dată în judecată pentru asta, dar continuă. Este incredibil că nu au fost deja trimiși în faliment. Și încă o predicție: falsurile profunde (deep fake) – adică filme și fotografii manipulate cu ajutorul AI pe internet – vor crește. În câțiva ani, falsurile profunde vor decide alegerile sau vor declanșa un război – sau chiar ambele.